Vector propriu și valoare proprie

În matematică , în special în algebra liniară , un vector propriu al unei funcții între spațiile vectoriale este un purtător care nu este nul, a cărui imagine este același vector înmulțit cu un număr (real sau complex) numită autovaloare. [1] Dacă funcția este liniară , vectorii proprii care au în comun aceeași valoare proprie, împreună cu vectorul zero, formează un spațiu vectorial , respectivul spațiu propriu. [2] Conceptul de vector propriu generalizat este conceptul de purtător radical sau vector propriu generalizat.

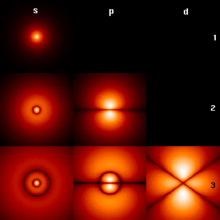

Valorile proprii și conceptele de vectori proprii sunt utilizate în multe domenii ale matematicii și fizicii ; problema găsirii valorilor proprii ale unei funcții liniare corespunde diagonalizării acesteia. Dacă un vector propriu este o funcție, se numește funcție proprie ; de exemplu, în mecanica clasică este foarte frecvent să se ia în considerare funcția exponențială ca funcție proprie derivată . Formalismele de acest tip permit descrierea multor probleme legate de un sistem fizic: de exemplu, modurile de vibrație ale unui corp rigid sau nivelurile de energie ale orbitalilor atomici și moleculari sunt asociate cu vectorii proprii ( stări proprii) ale funcțiilor ( observabile ) care determina dinamica lor.

Termenul vector propriu a fost tradus din cuvântul german Eigenvektor, inventat de Hilbert în 1904 . Eigen înseamnă „propriu”, „ciudat”. Chiar și în literatura italiană se găsește adesea vectorul propriu denumit purtător, purtător caracteristic latent sau purtător.

Introducere informală

Planul cartezian și spațiul euclidian sunt exemple particulare de spații vectoriale : fiecare punct din spațiu poate fi descris printr-un vector , reprezentat grafic printr-un segment care leagă originea de punct. Într-un spațiu vectorial este posibil să se efectueze transformări liniare pe vectorii care îl constituie: exemple de transformări liniare sunt rotațiile , omotetica (care permit amplificarea sau contractarea unui vector) și reflexiile (care permit transformarea unui vector în imagine oglindă în raport cu un punct, linie sau plan atribuit).

Un vector propriu pentru transformarea liniară este un vector că în urma aplicării nu își schimbă direcția, limitându-se la înmulțirea cu un scalar , valoarea proprie respectivă. Prin urmare, purtătorul poate schimba modulul (doar prin amplificare sau contractare) și spre (prin răsturnare):

- de sine versul din rămâne neschimbată, în timp ce dacă versul din schimbări

- de sine forma de rămâne neafectat, dacă modulul crește, dacă scade.

Vectorii proprii și valorile proprii sunt definite și utilizate în matematică și fizică în contextul spațiilor vectoriale care sunt mai complexe și abstracte decât cel tridimensional al fizicii clasice. Aceste spații pot avea dimensiuni mai mari de 3 sau chiar infinite (un exemplu este dat de spațiul Hilbert ). Chiar și pozițiile posibile ale unei coarde vibrante într-o chitară formează un spațiu de acest fel: o vibrație a coardei este apoi interpretată ca transformarea acestui spațiu și vectorii săi proprii (mai precis, funcțiile sale proprii ) sunt unde staționare .

Definiție

Este un spațiu vector pe un câmp , Care poate fi de exemplu câmpul numerelor reale sau domeniul complexului . Este un endomorfism al , Adică o transformare liniară :

De sine este un vector diferit de zero în Și este un scalar astfel încât:

asa de este un vector propriu de transformare , Și este valoarea sa proprie. [1]

Atâta timp cât este liniar, dacă este un vector propriu cu valoare proprie , apoi orice multiplu diferit de zero al lui este, de asemenea, un vector propriu cu aceeași valoare proprie . Într-adevăr, a spus orice vector astfel încât , cu , vei avea atâta timp cât este liniar. Dar fiind , avem asta:

acesta este .

Mai general, vectorii proprii având aceeași valoare proprie fixă , Împreună cu vectorul zero, generând un sub spațiu de numit spațiu propriu raportat la valoarea proprie , indicat de obicei cu . [2]

Spectrul de este ansamblul valorilor sale proprii. Raza spectrală a Este capătul superior al modulelor propriilor sale valori.

Descrierea matricei și vectorul propriu stâng

În cazul în care ambele în dimensiune peste , pentru orice alegere de baze în este asociat unic cu o matrice , numita matrice de transformare . [3] prin urmare, putem vorbi de o funcție liniară atât în ceea ce privește funcția (transformarea), cât și a matricei, iar formalismul matricei este adesea folosit pentru căutarea vectorilor proprii și a valorilor proprii.

Este vectorul coordonatelor lui în ceea ce privește o bază și ambele matricea de transformare reprezentativă față de aceeași bază. Are asta se numește vectorul propriu al dacă există un scalar valoarea proprie menționată astfel încât: [4]

În special, valorile proprii ale nu depind de baza aleasă.

Vectorul a spus vectorul propriu drept, deoarece un vector diferit de zero se spune vector propriu stâng dacă există astfel încât: [5]

unde este este vectorul transpus conjugat complex al . De sine este vectorul propriu stâng al cu valoare proprie , asa de De asemenea, este vectorul propriu drept al matricei conjugate transpuse cu valoare proprie complexul conjugat .

Fără alte specificații, „vector propriu” înseamnă vectorul propriu potrivit.

Auto-funcții

Adesea, vectorii proprii sunt la rândul lor funcții, caz în care vorbim despre funcțiile proprii ale unui operator . Un exemplu foarte semnificativ în matematică și fizică este cel al funcției de sine:

de „ operator diferențial derivat :

căruia îi corespunde valoarea proprie la fel de:

Polinom caracteristic

Definește caracteristica polinomială în variabilă asociat cu o matrice pătrată determinantul : [6]

unde este este matricea identitate cu același număr de rânduri ca . Rădăcinile polinomului caracteristic sunt toate valorile proprii ale . [7]

Două matrice reprezentând un endomorfism a unui spațiu vectorial în mărime peste acestea sunt similare și, în special, au același polinom caracteristic și, prin urmare, aceleași valori proprii. Este un instrument de mare importanță, care a făcut posibilă dezvoltarea unei metode generale pentru identificarea valorilor proprii și a vectorilor proprii ai unui endomorfism în cazul în care spațiul vectorial au dimensiuni finite. [8]

Polinomul permite, de asemenea, stabilirea existenței valorilor proprii și a vectorilor proprii pentru o aplicație liniară:

- Polinomul caracteristic al are grad , și, prin urmare, are cel mult rădăcini: rezultă că are cel mult valori proprii distincte.

- De sine Este închis algebric, atunci polinomul caracteristic are întotdeauna cel puțin o rădăcină: rezultă că are cel puțin o valoare proprie și, prin urmare, cel puțin un vector propriu. [9] În cazul real, acest lucru nu se întâmplă întotdeauna, de exemplu, puteți găsi valori proprii complexe.

- Dacă mărimea din este ciudat și este câmpul numerelor reale , polinomul caracteristic are grad impar, și, prin urmare, are întotdeauna cel puțin o rădăcină reală. De exemplu, orice endomorfism al are cel puțin un vector propriu.

- Mai mult, dacă polinomul caracteristic al atunci este complet factorizabil este triangolabil, adică există o bază a astfel încât matricea asociată este o matrice triunghiulară.

Diagonalizabilitate

Este un endomorfism al unui spațiu vectorial , adică o transformare liniară . Se spune că este diagonalizabil dacă există o bază de cu privire la care matrice o reprezintă este diagonală . [10] În special, baza care diagonalizează este compus din vectorii săi proprii.

În mod echivalent, o matrice pătrată este diagonalizabilă dacă este similară cu o matrice diagonală . [11] Matricea este deci diagonalizabil în câmpul căruia îi aparține dacă există o matrice inversabilă astfel încât:

adică:

Scris în ceea ce privește vectorii coloanei:

relația anterioară devine:

Vectorii coloană ai sunt deci vectori proprii ai , și elementele corespunzătoare ale matricei diagonale sunt valorile proprii respective. Inversibilitatea implică, de asemenea, independența liniară a vectorilor proprii, care formează o bază a spațiului.

Teorema spectrală

În cazul complexului cu dimensiuni finite, teorema spectrală spune că endomorfismul este normal dacă și numai dacă există o bază ortonormală a făcută din valorile sale proprii . [12] În acest caz, matricea Este unitar . Acest rezultat fundamental oferă condițiile pentru care este posibilă diagonalizarea unui operator liniar în raport cu o bază ortonormală: în cazul dimensiunilor finite, atunci când se întâmplă acest lucru, este posibil ca valorile proprii distincte să corespundă vectorilor proprii reciproc ortogonali și, prin urmare, spațiile egale sunt în sumă directă .

Descompunerea spectrală este un caz special al descompunerii Schur . Este, de asemenea, un caz special de descompunere a valorii singulare . Prin urmare, un operator normal poate fi scris ca o combinație liniară de proiectoare ortogonale pe spațiile egale, ai căror coeficienți sunt valorile proprii relative la fiecare spațiu egigen.

În cazul infinit-dimensional, normalitatea și în special „ autoadjuncția” nu garantează diagonalizabilitatea. În general, un operator normal nu mai poate fi scris ca o combinație liniară de proiectoare ortogonale. Cu toate acestea, printr-o măsură de proiecție , este posibil să se obțină o scriere integrală care să permită descrierea operatorului în termeni de spectru .

Spectrul unui operator

Într-un spațiu cu dimensiune infinită, definiția valorii proprii este identică cu cazul dimensiunii finite. Cu toate acestea, polinomul caracteristic nu este un instrument disponibil în acest caz, deoarece este necesar să se ia în considerare alte elemente ale spectrului.

Este un operator liniar limitat definit pe un complex spațial Banach . Define împreună rezolvarea de întregul de numere complexe astfel pentru care operatorul este inversabil, adică are un invers care este un operator liniar limitat. Acesta definește rezolvarea de functia:

Spectrul de este setul de numere complexe care nu aparțin setului de rezolvare, adică astfel încât operatorul nu este inversabil. [13]

De cand Este un operator liniar , dacă inversul său există, este liniar. În plus, pentru teorema graficului închis inversul unui operator liniar limitat este limitat. Rezultă că setul de rezolvare este setul de valori cedante bijectiv.

Spectrul unui operator nu poate fi gol și se pot distinge trei subseturi disjuncte:

- Definește spectrul punctual sau discret ansamblul valorilor proprii ale , adică numere complexe astfel încât:

- Prin urmare, valorile proprii sunt numerele pentru care , adică : functia nu este inversabil dacă nucleul său nu este constituit doar de vectorul nul, adică există vectori astfel pentru care există o astfel încât . Echivalent, este valoarea proprie a dacă și numai dacă nu este injectiv sau dacă și numai dacă .

- Definește spectrul continuu de setul de numere astfel pentru care nu este limitat, deși este dens definit.

- Definește spectrul rezidual setul de numere care nu sunt valori proprii și altele pentru care operatorul Nu are nicio imagine densă în . [14]

Operatori adăugați și autoadjuncti

Definiția operatorului adăugat diferă în funcție de faptul dacă vă aflați într-un spațiu Hilbert sau într-un spațiu Banach . Din această cauză, spectrul unui operator definit pe un spațiu Banach coincide cu cel al adjunctului său, în timp ce într-un spațiu Hilbert, denotând adjunctul lui cu , avem asta:

De asemenea, dacă aparține spectrului rezidual al , asa de aparține spectrului punctual al adjunctului . Dacă în schimb aparține spectrului punctual al , atunci aparține atât spectrului punctual, cât și spectrului rezidual al . [15]

De sine este autoadjunct pe un spațiu Hilbert, avem și:

- nu are spectru rezidual.

- este un subset de , adică valorile proprii sunt reale.

- Vectorii proprii în raport cu valorile proprii distincte sunt ortogonali.

Aplicații

Studiul valorilor proprii și al vectorilor proprii legați de o transformare liniară, care constă în „autoteorie, este una dintre principalele probleme cu care se confruntă„ algebra liniară și are aplicații vaste în diferite domenii ale științei.

Operatori în mecanica cuantică

În mecanica cuantică a unui purtător (numit în acest context autoket ) este asociat cu un obiect considerat de „stare” sau stat propriu . În termeni informali, pentru a evidenția faptul că, în general, nu cunosc această stare, este descrisă ca o combinație liniară (sau suprapunere ) de vectori proprii (stări proprii) cunoscută de un operator. Operatorul în cauză „reprezintă” un anumit observabil , care corespunde unei mărimi fizice, de exemplu operatorul ' hamiltonian Este asociată cu „ energia obiectului. Dacă alegeți să scrieți starea obiectului printr-o combinație liniară de vectori proprii ai , la fiecare vector propriu se asociază o posibilă valoare a energiei obiectului, care este valoarea sa proprie:

O astfel de reprezentare matricială a „ ecuației Schrödinger independent de timp este posibilă dacă, așa cum se întâmplă adesea (de exemplu, prin studierea stărilor legate), este o funcție pătrată integrabilă : aceste funcții formează un spațiu Hilbert infinit-dimensional cu produsul intern .

Operația care prin aplicarea returnează una dintre valorile proprii este acea măsură și „colapsează” sau „precipită” starea obiectului într-o stare proprie a măsurării observabile. Măsura modifică iremediabil starea sistemului, care se află într-un stat propriu foarte specific. Setul de valori (valori proprii) posibile pentru măsurarea unui observabil este spectrul de magnitudine al operatorului asociat cu acesta. Având de cuantificat o cantitate fizică, este de asemenea necesar ca. este un operator hermitian : în acest fel, valorile proprii sunt reale , iar stările proprii (normalizate) formează o bază ortonormală a spațiului. Datorită produsului intern este posibil să proiectăm statul propriu pe baza statelor proprii ale altui operator, cum ar fi baza vectorilor proprii dell ' operator de poziție . Proiecția:

Acesta definește funcția de undă , o descriere probabilistică a poziției obiectului. Funcția de undă este deci o ' funcție proprie a corespunzând valorii proprii :

Produsul interior din spațiul Hilbert este dat și de:

unde este Indică conjugarea complexă . Aceasta limitează alegerea spațiului Hilbert la spațiul funcțiilor pătrate integrabile pe domeniul ales , care poate fi totul .

Teoria numerelor

Studiul valorilor proprii ale unei matrice are, de asemenea, aplicații importante în teoria numerelor . În special, se presupune că unele statistici non-banale asupra zero-urilor funcției zeta Riemann , cum ar fi cele privind distanța dintre zerouri consecutive, sunt aceleași cu cele referitoare la matricile aleatorii hermitiene (cu privire la măsura Haar ) a dimensiune a se strădui să la nesfârșit. În plus, s-a presupus că distribuția valorilor funcției zeta este bine aproximată Riemann, în medie, de valorile asumate de polinomul caracteristic al acestor matrice. Considerații analoge pot fi făcute asupra altor familii cu funcții speciale , cum ar fi funcțiile L ale lui Dirichlet , implicând și alte familii de matrice aleatorii, cum ar fi matricile simplectice sau ortogonale . Această conexiune a dus la înflorirea unui număr de noi presupuneri în teoria numerelor. [16]

Autoface

În procesarea digitală a imaginilor , imaginile fețelor pot fi văzute ca vectori ale căror componente sunt luminozitatea pixelilor individuali. [17] Dimensiunea spațiului vectorial în care sunt stabilite este egală cu numărul de pixeli, iar vectorii proprii ai unei anumite matrice, numita matrice de covarianță , se numesc autofacie. Acestea sunt foarte utile pentru exprimarea fiecărei fețe ca o combinație liniară a acestor autofacce și, prin urmare, sunt, de asemenea, un instrument excelent de compresie a datelor pentru a stoca și identifica un număr mai mare de fețe.

Tensor de inerție

În mecanică , vectorii proprii ai tensorului de inerție definesc axele principale ale unui corp rigid. Cantitatea tensorului de inerție este o cheie, care este necesară pentru a determina rotația unui corp rigid în jurul centrului său de greutate . Vectorii proprii ai tensorului de deformare definesc axele principale de deformare.

Exemple

Exemple în plan

Printre transformările planului cartezian se pot distinge următoarele cazuri speciale:

- Rotiți unghiul în sens invers acelor de ceasornic . De sine nu este un multiplu întreg al non esiste alcun autovettore, infatti ogni vettore viene ruotato e cambia di direzione. Se invece , con intero dispari, ogni vettore viene trasformato nel suo opposto, quindi ogni vettore non nullo è autovettore della rotazione con autovalore . Se invece è pari la trasformazione non è altro che l'identità, per cui ogni vettore non nullo è autovettore con autovalore .

- La rotazione può essere rappresentata dalla seguente matrice:

- Riflessione rispetto a una retta passante per l'origine. I vettori in restano fermi e sono quindi autovettori con autovalore , mentre quelli della retta perpendicolare a e passante per l'origine vengono ribaltati, e quindi sono autovettori con autovalore . Non esistono altri autovettori.

- La riflessione, nel caso di retta r orizzontale, può essere rappresentata dalla seguente matrice:

- Omotetia . Ogni vettore viene moltiplicato per uno scalare e quindi tutti i vettori non nulli sono autovettori con autovalore .

- L'omotetia può essere rappresentata dalla seguente matrice:

- Proiezione ortogonale su una retta passante per l'origine. I vettori su restano fermi e quindi sono autovettori con autovalore , mentre i vettori sulla retta ortogonale a e passante per l'origine sono mappati tutti sull'origine e quindi sono autovettori con autovalore . Non ci sono altri autovettori.

- La proiezione ortogonale può essere rappresentata dalla seguente matrice:

Esempi nello spazio

Non tutte le trasformazioni del piano e dello spazio ricadono in una delle 4 tipologie viste negli esempi del piano sopra riportate.

In generale, un endomorfismo di (cioè una trasformazione lineare di in sé) è rappresentabile tramite una matrice quadrata con n righe. Si consideri per esempio l'endomorfismo di indotto dalla matrice:

Se si considera il vettore :

e si esegue la moltiplicazione fra matrice e vettore , si vede che:

Quindi l'endomorfismo rappresentato da ha un autovettore dato da con autovalore 2. Per trovarne tutti gli autovalori si deve scrivere il polinomio caratteristico di . Poiché la trasformazione è già scritta in forma di matrice, si procede con il calcolarne il polinomio caratteristico:

Quindi gli autovalori di sono 2, 1 e −1. I tre autovettori ortogonali sono:

Per quanto detto prima, la trasformazione assume una forma molto semplice rispetto a questa base: ogni vettore in può essere scritto in modo unico come:

e dunque si ha:

Data infine una trasformazione lineare , si è visto che se il polinomio caratteristico di ha tutte le radici in con molteplicità 1, allora è diagonalizzabile. Se invece il polinomio caratteristico di ha tutte le radici in ma alcune di esse hanno molteplicità maggiore di 1, allora non è necessariamente diagonalizzabile. Ad esempio la matrice:

che rappresenta la trasformazione della Gioconda in figura ha come polinomio caratteristico , e non è diagonalizzabile per .

Esempi di calcolo

Data la matrice di trasformazione:

il vettore:

è un autovettore con autovalore 2. Infatti:

Per contro il vettore:

non è un autovettore in quanto il vettore trasformato è:

e, come si nota facilmente, manca la proporzionalità tra il vettore trasformato e il vettore originale , condizione necessaria per il parallelismo.

Come secondo esempio, si consideri la matrice di trasformazione:

è facile verificare che i vettori:

sono autovettori con autovalori 3 e 1 rispettivamente.

Note

- ^ a b S. Lang , Pag. 220 .

- ^ a b S. Lang , Pag. 221 .

- ^ S. Lang , Pag. 104 .

- ^ S. Lang , Pag. 105 .

- ^ Jim Lambers - The Unsymmetric Eigenvalue Problem

- ^ S. Lang , Pag. 227 .

- ^ S. Lang , Pag. 228 .

- ^ Nella pratica gli autovalori di grandi matrici non vengono calcolati usando il polinomio caratteristico, esistendo metodi numerici più veloci e sufficientemente stabili.

- ^ S. Lang , Pag. 223 .

- ^ S. Lang , Pag. 114 .

- ^ S. Lang , Pag. 115 .

- ^ S. Lang , Pag. 251 .

- ^ Reed, Simon , Pag. 188 .

- ^ Lo shift unilaterale su ne fornisce un esempio: tale operatore è una isometria , ed è quindi limitato ma non invertibile poiché non è surriettivo.

- ^ Reed, Simon , Pag. 194 .

- ^ ( EN ) Jon Keating , L-functions and the Characteristic Polynomials of Random Matrices , in Francesco Mezzadri e Nina Snaith (a cura di), Recent perspectives in random matrix theory and number theory , Cambridge, Cambridge University Press, 2005, pp. 251-278, ISBN 978-0-521-62058-1 .

- ^ A. Xirouhakis, G. Votsis e A. Delopoulus, Estimation of 3D motion and structure of human faces ( PDF ), Online paper in PDF format, National Technical University of Athens, 2004.

Bibliografia

- Serge Lang, Algebra lineare , Torino, Bollati Boringhieri , 1992, ISBN 88-339-5035-2 .

- ( EN ) Michael Reed, Barry Simon, Methods of Modern Mathematical Physics, Vol. 1: Functional Analysis , 2ª ed., San Diego, California, Academic press inc., 1980, ISBN 0-12-585050-6 .

- Marius Stoka, Corso di geometria , Cedam, 1995, ISBN 978-88-13-19192-4 .

- ( EN ) Serge Lang , Algebra, 3rd edition , Springer , 2002, ISBN 0-387-95385-X .

- ( EN ) Steven Roman, Advanced Linear Algebra , Springer, 1992, ISBN 0-387-97837-2 .

- ( EN ) Paul R. Halmos , Finite-dimensional Vector Spaces , Springer, 1993, ISBN 0-387-90093-4 .

- ( EN ) Werner H. Greub, Linear Algebra, 4th ed. , Springer, 1981, ISBN 0-387-90110-8 .

- ( EN ) Jim Hefferon, Linear Algebra , Online book , St Michael's College, Colchester, Vermont, USA 2001.

- ( EN ) Gene H. Golub e Charles F. van Loan, Matrix computations, 3rd Edition , Johns Hopkins University Press, 1996, ISBN 0-8018-5414-8 .

- ( EN ) Nelson Dunford e Jacob Schwartz , Linear Operator. Part I General Theory , Wiley-Interscience, 1958, ISBN 0-471-60848-3 .

- ( EN ) VG Prikazchikov, Eigen values of differential operators, numerical methods . accessibile in Encyclopaedia of Mathematics

- ( EN ) AB Bakushinskii, Eigen values of integral operators, numerical methods . accessibile in Encyclopaedia of Mathematics

- ( EN ) Leonid V. Kantorovič e GP Akilov, Functional analysis , Pergamon Press, 1982, ISBN 978-14-83-11532-0 .

Voci correlate

- Autofunzione

- Autostato

- Decomposizione ai valori singolari

- Decomposizione di Schur

- Diagonalizzabilità

- Forma canonica di Jordan

- Polinomio caratteristico

- Raggio spettrale

- Similitudine fra matrici

- Spettro (matematica)

- Teorema spettrale

- Teoremi di Gerschgorin

- Teorema di Schur-Horn

- Trasformazione lineare

- Valore singolare

- Metodo delle potenze inverse : metodo numerico per trovare gli autovalori

Altri progetti

-

Wikizionario contiene il lemma di dizionario « autovettore »

Wikizionario contiene il lemma di dizionario « autovettore »

-

Wikizionario contiene il lemma di dizionario « autovalore »

Wikizionario contiene il lemma di dizionario « autovalore » -

Wikiversità contiene risorse su autovettore e autovalore

Wikiversità contiene risorse su autovettore e autovalore

Collegamenti esterni

- ( EN ) TS Pigolkina; VS Shul'man, Eigen vector , in Encyclopaedia of Mathematics , Springer e European Mathematical Society, 2002.

- ( EN ) VL Popov, Root vector , in Encyclopaedia of Mathematics , Springer e European Mathematical Society, 2002.

- ( EN ) Eigenvector in MathWorld

- ( EN ) TS Pigolkina, VS Shul'man: Eigen vector Eigen vector in Encyclopaedia of Mathematics

- ( EN ) Earliest Known Uses of Some of the Words of Mathematics: E - vedi eigenvector e termini correlati , su members.aol.com .

- ( EN ) Numerical solution of eigenvalue problems Edited by Zhaojun Bai, James Demmel, Jack Dongarra , Axel Ruhe, Henk van der Vorst

- Calcolatrici online

- Calculator for Eigenvalues nel sito di Arndt Brünner

- Online Matrix Calculator presso BlueBit Software

- Matrix calculator in WIMS, WWW Interactive Multipurpose Server, presso l'Université Nice Sophia Antipolis

| Controllo di autorità | LCCN ( EN ) sh85041390 · GND ( DE ) 4013802-1 |

|---|

![{\bigl [}{\begin{smallmatrix}2&1\\1&2\end{smallmatrix}}{\bigr ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dcacd8bee0f5c4d9f5e8e3fc2c4932447e0e2aec)

![\scriptstyle v_{1}={\bigl [}{\begin{smallmatrix}1\\1\end{smallmatrix}}{\bigr ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bd908778998b9669d6445cb12db4b536980773cf)

![\scriptstyle v_{2}={\bigl [}{\begin{smallmatrix}1\\-1\end{smallmatrix}}{\bigr ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a8a589d0af0fe7a4c60324da3be799b8a15aa856)

![{\bigl [}{\begin{smallmatrix}1\\3\end{smallmatrix}}{\bigr ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dc342fe475c1f3e16d616bda8753bd64e6c9e34a)

![{\bigl [}{\begin{smallmatrix}0\\1\end{smallmatrix}}{\bigr ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6eacfd7e23aaf01c0ae72792d11542f24451804c)