Indicele de corelație Pearson

În statistică , indicele de corelație Pearson (numit și coeficient de corelație liniar [1] sau coeficient de corelație Pearson sau coeficient de corelație Bravais-Pearson ) între două variabile statistice este un indice care exprimă o posibilă relație de linearitate între ele. [1] Conform inegalității lui Cauchy-Schwarz are o valoare între Și unde este corespunde corelației liniare pozitive perfecte, corespunde unei absențe a corelației liniare e corespunde corelației liniare negative negative. A fost dezvoltat de Karl Pearson dintr-o idee introdusă de Francis Galton în 1880; formula matematică a fost derivată și publicată de Auguste Bravais în 1844. [2] [3] [4] Desemnarea coeficientului este, de asemenea, un exemplu al legii lui Stigler .

Definiție

Având în vedere două variabile statistice Și , Indicele de corelație Pearson este definit ca covarianța lor împărțită la produsul abaterilor standard ale celor două variabile:

unde este Este covarianța dintre Și Și sunt cele două abateri standard .

Coeficientul își asumă întotdeauna valori între Și [5]

Corelația și independența

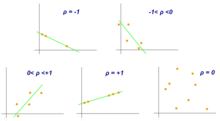

În practică, se disting diferite „tipuri” de corelație.

- De sine , variabilele Și Se spune că sunt direct legate sau corelate pozitiv;

- de sine , variabilele Și Se spune că sunt necorelate;

- de sine , variabilele Și spun că sunt invers corelate sau corelate negativ.

Mai mult, pentru corelația directă (și în mod similar pentru cea inversă) distingem:

- de sine are o corelație slabă;

- de sine are o corelație moderată;

- de sine are o corelație puternică.

Dacă cele două variabile sunt independente, atunci indicele de corelație este egal cu 0. Nu merită concluzia opusă: cu alte cuvinte, incorelația este o condiție necesară , dar nu o condiție suficientă pentru independență. De exemplu, având în vedere distribuția

| X: | -3 | -2 | -1 | 0 | 1 | 2 | 3 |

|---|---|---|---|---|---|---|---|

| Y: | 9 | 4 | 1 | 0 | 1 | 4 | 9 |

avem asta Și nu sunt independenți, deoarece sunt legați de relație , dar .

Ipoteza absenței autocorelației este mai restrictivă și implică cea a independenței între două variabile.

Indicele de corelație se menține în prezența unei corelații liniare pozitive perfecte (adică , cu ), în timp ce este valabil în prezența unei corelații liniare negative negative (adică , cu ).

Valori apropiate de (sau ) pot fi măsurate și în prezența unor relații neliniare. De exemplu, următoarea relație pătratică:

| X: | 1 | 2 | 3 | 4 |

|---|---|---|---|---|

| Y: | 1 | 4 | 9 | 16 |

produce un coeficient .

Generalizare la mai mult de două variabile

Indicii de corelație ai variabilele pot fi prezentate într-o matrice de corelație , care este o matrice pătrată de mărime având variabilele în studiu atât pe rânduri, cât și pe coloane. Matricea este simetrică , adică , iar coeficienții de pe diagonală in aceea

Proprietăți matematice

O valoare a indexului de corelație egală cu sau corespunde punctelor care sunt exact pe o linie dreaptă. Coeficientul de corelație al lui Pearson este simetric:

O proprietate matematică caracteristică a coeficientului de corelație al lui Pearson este aceea că acesta nu variază în raport cu modificările individuale ale poziției și scalei celor două variabile. Adică ne putem transforma în și transformă în unde este Și sunt constante reale cu fără a modifica coeficientul de corelație.

Notă

- ^ A b Glosar Istat pe www3.istat.it (depus de 'url original 31 decembrie 2011).

- ^ (F. Galton) (24 septembrie 1885), „The British Association: Section II, Anthropology: Opening speech by Francis Galton, FRS etc., președintele Institutului antropologic, președintele secțiunii,„ Nature, 32 (830) ): 507-510. .

- ^ Karl Pearson (20 iunie 1895) „Note privind regresia și moștenirea în cazul a doi părinți”, Proceedings of the Royal Society of London, 58: 240-242. .

- ^ Stigler, Stephen M. (1989). „Relatarea lui Francis Galton despre invenția corelației”. Știința statistică. 4 (2): 73–79. .

- ^ Ross , p. 117.

Bibliografie

- Sheldon M. Ross, Introducere în statistici , ediția a II-a, Maggs Publisher, 2014, ISBN 8891602671 .

Elemente conexe

- Coeficientul de corelație a rangului Spearman

- Coeficientul de corelație al rangului Kendall

- Regresie liniara

- Corelație (statistici)

- Karl Pearson

- Francis Galton , primul care a introdus litera R (ca prescurtare a „regresiei”) chiar dacă a folosit un coeficient diferit, ca normava folosind intervalul intercuartil.

linkuri externe

- (EN) Pearson Correlation Index , of Encyclopedia Britannica , Encyclopædia Britannica, Inc.

| Controlul autorității | GND (DE) 4165345-2 |

|---|