Incorporarea graficului de cunoștințe

În disciplina învățării prin relații, încorporarea cunoștințelor de încorporare a graficului de cunoștințe ( KGE ) în limba engleză, denumită și învățarea prin reprezentare a cunoștințelor ( KRL ) sau învățarea multi-relațională [1] este un domeniu al învățării automate care se ocupă cu învățarea unui reprezentarea în dimensiuni reduse a entităților și relațiilor care alcătuiesc un grafic al cunoașterii sau numit și grafic al cunoașterii, încercând să păstreze semnificația lor semantică. [1] [2] [3] Prin exploatarea reprezentării încorporate a graficului de cunoștințe este posibil să se utilizeze acest tip de informații pentru diverse aplicații, cum ar fi predicția legăturilor, clasificarea triplă, recunoașterea entității, gruparea și extragerea relațiilor. [1] [4]

Definiție

Un grafic al cunoștințelor sau un grafic al cunoștințelor, , este o colecție de entități , relații , și fapte . [5] Un fapt este un triplu care denotă o legătură între cap sau „cap”, iar coada sau coada, a triplului în sine. O altă notație care este frecvent utilizată în literatură pentru a reprezenta un triplu (sau un fapt) este sau . Această notație se numește cadrul de descriere a resurselor (RDF). [1] [5] Un grafic de cunoștințe este utilizat pentru a reprezenta cunoștințele legate de un domeniu și, prin exploatarea reprezentării structurate a acestuia, este posibil să se deducă o bucată de cunoaștere nouă din acesta după niște pași de rafinare. [6] Cu toate acestea, în zilele noastre, trebuie să luăm în considerare datele rare și ineficiența de calcul în utilizarea acestora într-o aplicație reală. [3] [7]

Încorporarea unui grafic de cunoștințe traduce fiecare entitate și relație a graficului, într-un vector de dimensiune , numită și dimensiunea de încorporare. [7] În cazul general, putem avea dimensiuni de încorporare diferite pentru entități iar pentru relații . [7] Colecția de vectori a tuturor entităților și a relațiilor unui grafic de cunoaștere este o reprezentare mai densă și mai eficientă a domeniului care poate fi mai ușor exploatată pentru multe cazuri de utilizare. [7]

Incorporarea unui grafic al cunoștințelor este caracterizată prin patru aspecte diferite: [1]

- Spațiul de reprezentare: este spațiul dimensional mai mic decât cel inițial care este utilizat pentru a reprezenta entități și relații. [1]

- Funcția de notare: este o măsură a corectitudinii reprezentării încorporate a triplelor. [1]

- Model de codificare: este modul în care reprezentarea încorporată a entităților și a relațiilor interacționează între ele. [1]

- Informații suplimentare: Orice informații suplimentare din graficul de cunoștințe care pot fi utilizate pentru a îmbogăți reprezentarea încorporată. [1] De obicei, pentru fiecare informație suplimentară, este definită o funcție de notare ad hoc care va fi apoi integrată cu funcția generală de notare a modelului. [1] [5] [8]

Procedura de încorporare

Toate diferitele modele de încorporare ale unui grafic de cunoștințe urmează aproximativ aceeași procedură. [7] În primul rând, pentru a învăța o reprezentare încorporată a unui grafic de cunoștințe, vectorii încorporați ai entităților și relațiilor sunt inițializați la valori aleatorii [7] Apoi, începând de la un set de antrenament (sau set de antrenament ), până la o oprire condiția nu este atinsă, algoritmul optimizează continuu reprezentarea încorporată a elementelor care alcătuiesc graficul de cunoștințe. [7] De regulă, condiția de oprire este dată de suprasolicitarea față de setul de antrenament. [7] La fiecare iterație, se prelevează un set de tripluri din setul de antrenament, iar pentru fiecare triplu al acestui set se generează un triplu corupt aleatoriu, adică un triplu în care faptul pe care îl reprezintă nu corespunde unui adevăr al graficului de cunoaștere. [7] Corupția unui triplu implică înlocuirea capului, sau cozii, (sau a ambelor) triplului cu o altă entitate care face faptul fals. [7] Triplul original, împreună cu triplul corupt, se adaugă la setul care constituie setul de antrenament, iar ulterior încorporarea elementelor grafului sunt optimizate urmând valoarea funcției de punctare. [5] [7] La sfârșitul algoritmului, încorporarea învățată ar trebui să poată extrage semnificația semantică din triple și ar trebui să poată clasifica corect triplele adevărate, dar care nu sunt prezente în cadrul gradului de cunoaștere. [5]

Pseudo cod

Următorul este pseudo codul care este utilizat în general pentru procedura de încorporare. [7] [9]

Algoritmul de calcul al entității și încorporarea relațiilor

input: Având un set de antrenamentIndicatori de performanta

Acești indici sunt adesea utilizați pentru a măsura calitatea încorporării unui model. Simplitatea indicilor le face aplicabile pentru a evalua performanța unui algoritm de încorporare chiar și în dimensiuni mari. [10] Dat un set de predicții clasificate după un model, este posibil să se definească trei indici de performanță diferiți: Hits @ K, MR și MRR. [10]

Hits @ K

Hits @ K sau pe scurt, H @ K, este un indice de performanță care cuantifică probabilitatea de a găsi predicția corectă printre primele K cele mai bune predicții ale modelului. [10] Se folosește de obicei . [10] Hits @ K reflectă acuratețea unui model de încorporare în prezicerea corectă a relației dintre două entități. [10]

Hits @ K

Valorile mai mari înseamnă performanță predictivă mai bună. [10]

Rang mediu (MR)

Rangul mediu este media poziției de clasare a unui obiect prezisă de un model dintre toate elementele posibile care pot fi prezise. [10]

Cu cât valoarea este mai mică, cu atât este mai fiabil modelul de încorporare. [10]

Rangul reciproc mediu (MRR)

Rangul reciproc mediu măsoară numărul de triple care sunt corect prezise. Dacă primul triplu este corect prezis, atunci se adaugă 1, dacă al doilea triplu este corect prezis, se adaugă , si asa mai departe. [10]

Un index mai mare este sinonim cu un model mai bun. [10]

Aplicații

Sarcină de formare automată

Completarea graficului de cunoștințe (KGC) în limba engleză este un set de tehnici de inferență pentru a extrage noi cunoștințe din reprezentarea încorporată a graficului de cunoștințe. [11] În special, această tehnică completează un triplu deducând entitatea sau relația lipsă. [11] Sub-sarcinile corespunzătoare se numesc predicție de entitate sau de legătură, adică sarcina de a prezice entitatea din încorporare sau, deducând cea mai probabilă relație care leagă două entități. [11]

Clasificarea triplelor este o problemă binară de clasificare. [1] Având în vedere un triplu, modelul de încorporare evaluează plauzibilitatea unui triplu folosind reprezentarea sa încorporată pentru a determina dacă faptul este adevărat sau fals. [11] Decizia de clasificare se ia pe baza funcției de notare a modelului în raport cu un prag dat. [11] Clusterizarea este o altă aplicație care exploatează reprezentarea încorporată a graficului de cunoștințe împrăștiat pentru a condensa reprezentarea entităților cu semantică vecină similară într-un spațiu bidimensional. [4]

Aplicații în viața de zi cu zi

Utilizarea încorporării graficelor de cunoștințe este din ce în ce mai răspândită în multe aplicații. În cazul sistemelor de recomandare , utilizarea încorporării în graficele de cunoștințe poate ajuta la depășirea limitărilor învățării prin întărire . [12] [13] Pentru a instrui acest tip de sisteme de recomandare este necesar să aveți o cantitate mare de informații disponibile de la utilizatori, dar exploatând utilizarea unui grafic care a fost deja construit pentru a reprezenta cunoștințele cu privire la corelația elementelor și folosind încorporarea, se pot deduce recomandări, depășind limitările anterioare. [12] Reutilizarea medicamentelor este reutilizarea unui medicament aflat deja pe piață, dar în scop terapeutic diferit de cel inițial. Prin exploatarea numeroaselor informații din literatură, este posibil să se genereze un grafic de cunoștințe cu informații biomedicale și prin utilizarea sarcinii de predicție a legăturii, este posibil să se prevadă o nouă legătură între un medicament și o boală. [14] Incorporarea graficelor de cunoștințe poate fi utilizată și în domeniul politicilor sociale. [4]

Modele

Având în vedere o colecție de tripluri (sau fapte) , încorporarea graficului de cunoștințe produce, pentru fiecare entitate și relație prezentă în grafic, un vector continuu care reprezintă semantica sa. [7] denotă încorporarea corespunzătoare a unui triplu cu Și , unde este este dimensiunea de încorporare a entității și pentru relații. [7] Funcția de notare a unui model dat este notată cu și măsoară distanța de la încorporarea capului de încastrarea cozii, având în vedere încorporarea relației sau, cu alte cuvinte, cuantifică plauzibilitatea reprezentării întruchipate a unui fapt. [5]

Rossi și colab. a propus o taxonomie a modelelor de încorporare și identifică trei familii principale: modele de descompunere a tensorilor, modele geometrice și modele de învățare profundă. [5]

Modele de descompunere ale tensorului

Modelele de descompunere tensorială sunt o familie de modele de încorporare a graficului de cunoștințe care utilizează o matrice multidimensională pentru a reprezenta graficul, [1] [5] [15], care este doar parțial cunoscibil datorită faptului că graficul de cunoștințe nu poate reprezenta pe deplin un domeniu . [5] În special, aceste modele utilizează un tensor tridimensional, care este apoi descompus în vectori cu dimensiuni inferioare, care sunt întruchiparea entităților și a relațiilor. [5] [15] Tensorul este o metodologie adecvată pentru a reprezenta un grafic de cunoaștere, deoarece ia în considerare existența sau nu a relațiilor dintre entități, [15] și din acest motiv este simplu și nu este nevoie de cunoștințe anterioare despre structura rețelei, [16] făcând această clasă de modele ușoare, ușor de antrenat chiar dacă suferă de raritate și dimensionalitate ridicată a datelor. [5] [15]

Modele biliniare

Această familie de modele folosește o ecuație liniară pentru a încorpora conexiunea dintre entități conectate printr-o relație. [1] În special, reprezentarea încorporată a relațiilor este o matrice bidimensională. [5] Aceste modele, în timpul procedurii de încorporare, utilizează doar fapte individuale pentru a calcula reprezentarea încorporată și ignoră alte asocieri la aceeași entitate sau relație. [17]

- DistMult [18] : Deoarece matricea de încorporare a relației este o matrice diagonală, [5] funcția de notare nu poate distinge faptele asimetrice. [5] [17]

- ComplEx [19] : Cum DistMult folosește o matrice diagonală pentru a reprezenta relațiile. [5] [15] ComplEx adaugă o reprezentare în spațiul vectorial complex și produsul Hermitian și este capabil să distingă fapte simetrice și asimetrice. [5] [15] Această abordare este scalabilă chiar și într-un grafic larg de cunoștințe în termeni de timp și costuri de spațiu. [19]

- ANALOGIE [20] : Acest model codifică structura analogică a graficului de cunoștințe în încorporare pentru a simula raționamentul inductiv. [1] [5] [20] Folosind o funcție obiectivă diferențiată, ANALOGIA are o bună generalitate teoretică și scalabilitate de calcul. [20] Se arată că încorporarea produsă de ANALOGY poate fi văzută ca un caz special al încorporării DistMul, ComplEx și HolE. [20]

- SimplE [21] : Acest model este îmbunătățirea descompunerii canonice poliadice (CPD), în care se învață un vector de imersiune pentru relație și doi vectori de imersie independenți pentru fiecare entitate, în funcție de faptul că este capul sau coada, de fapt, a cunoștințelor grafic. [21] SimplE rezolvă problema învățării independente a celor două entități încorporate utilizând o relație inversă și calculând media scorului CPD de Și . [7] [15] În acest mod, SimplE colectează relația dintre entități așa cum apar în rolul de subiect sau obiect în cadrul unui fapt și este capabil să încorporeze relații asimetrice. [5]

Modele neliniare

- HolE [22] : HolE folosește corelația circulară pentru a crea o reprezentare încorporată a graficului de cunoștințe, [22] care poate fi văzută ca o compresie a produsului matricial, dar este mai eficientă și scalabilă din punct de vedere al calculului, menținând în același timp capacitatea de a exprima o relație asimetrică întrucât corelația circulară nu este comutativă. [17] HolE leagă încorporări holografice și complexe, deoarece atunci când este utilizat împreună cu Fourier poate fi văzut ca un caz special al ComplEx. [1]

- TuckER [23] : TuckER vede gradul de cunoaștere ca un tensor care ar putea fi descompus folosind descompunerea Tucker într-o colecție de vectori, sau întruchipări de entități și relații, cu un nucleu comun. [5] [23] Greutățile tensorului central sunt învățate împreună cu întruchipările și reprezintă nivelul de interacțiune al entităților. [24] Fiecare entitate și relație are propria sa dimensiune de incluziune, iar dimensiunea tensorului principal este determinată de dimensiunea entităților și de relația cu care interacționează. [5] Incorporarea subiectului și a obiectului unui fapt sunt adăugate în același mod, făcând TuckER complet expresiv, iar alte modele de încorporare precum RESCAL, DistMult, ComplEx și SimplE pot fi exprimate ca o formulare specială a TuckER. [23]

Modele geometrice

Spațiul geometric definit de această familie de modele codifică relația ca o transformare geometrică între capul și coada unui triplu. [5] Din acest motiv, pentru a calcula încastrarea cozii, trebuie aplicată o transformare încorporarea capului și o funcție la distanță este folosit pentru a măsura bunătatea încorporării sau pentru a evalua fiabilitatea unui fapt. [5]

Modelele geometrice sunt similare modelului de descompunere tensorială, dar principala diferență dintre cele două este că trebuie să păstreze aplicabilitatea transformării în spațiul geometric în care este definit. [5]

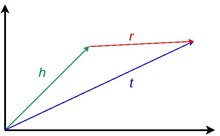

Modele pur translaționale

Această clasă de model este inspirată de ideea de invarianță a traducerii introdusă în word2vec . [7] Un model translational pur se bazează pe faptul că vectorii de încorporare ai entităților sunt apropiați unul de celălalt după aplicarea unei traduceri relaționale corecte în spațiul geometric în care sunt definite. [17] Cu alte cuvinte, dat fiind un fapt, atunci când încorporarea capului se adaugă la încorporarea relației, rezultatul așteptat ar trebui să fie încorporarea cozii. [5] Apropierea entităților încorporate este dată de o anumită măsură a distanței și cuantifică fiabilitatea unui triplu. [15]

- TransE [9] : Acest model folosește o funcție de notare care forțează încorporările să satisfacă o ecuație simplă de sumă vectorială în fiecare fapt în care apar: . [7] Încorporarea va fi corectă dacă fiecare entitate și relație apare într-un singur fapt și, din acest motiv, în practică nu reprezintă bine relațiile unu la mulți, mulți la unu și asimetrice.

- TransH [25] : Este o evoluție a TransE care introduce un hiperplan ca spațiu geometric pentru a rezolva problema reprezentării corecte a tipurilor de relații. [25] În TransH, fiecare relație are o reprezentare încorporată diferită, pe un hiperplan diferit, pe baza entităților cu care interacționează. [7] Prin urmare, pentru a calcula, de exemplu, funcția de notare a unui fapt, reprezentarea încorporată a capului și a cozii trebuie proiectată utilizând o matrice de proiecție relațională pe hiperplanul corect al relației. [1] [7]

- TransR [26] : TransR este o evoluție a TransH deoarece folosește două spații diferite pentru a reprezenta reprezentarea încorporată a entităților și a relațiilor, [1] [17] și separă complet spațiul semantic al entităților de cel al relațiilor. [7] TransR folosește, de asemenea, o matrice de proiecție relațională pentru a traduce încorporarea entităților în spațiul relațional. [7]

- TransD [27] : Având în vedere un fapt, în TransR, capul și coada unui fapt ar putea aparține a două tipuri diferite de entități, de exemplu în triplul Obama și SUA sunt două entități, dar una este o persoană, iar cealaltă este o țară. [7] [27] Înmulțirea matricei este o procedură costisitoare în TransR, care este utilizată pentru a calcula proiecția. [7] [27] În acest context, TransD folosește doi vectori pentru fiecare pereche relație-entitate pentru a calcula o cartografiere dinamică care înlocuiește matricea de proiecție prin reducerea complexității dimensionale. [1] [7] [27] Primul vector este utilizat pentru a reprezenta semnificația semantică a entităților și a relațiilor, al doilea pentru a calcula matricea de mapare. [27]

- TransA [28] : Toate modelele de traducere definesc o funcție de notare în spațiul lor de reprezentare, dar simplifică excesiv această valoare. [28] Întrucât reprezentarea vectorială a entităților și a relațiilor nu este perfectă, o traducere pură a poate fi departe de , iar o distanță euclidiană sferică echipotențială face dificilă distingerea entității care este cea mai apropiată. TransA, pe de altă parte, introduce o distanță Mahalanobis adaptativă la realizările greutății, împreună cu suprafețe eliptice pentru a elimina ambiguitatea. [1] [7] [28]

Modele translaționale cu informații suplimentare

Informații suplimentare pot fi asociate cu fiecare element din graficul de cunoștințe împreună cu modurile lor comune de reprezentare. [1] Fiecare entitate și relație, de fapt, pot fi îmbogățite cu descrieri textuale, greutăți, constrângeri și multe altele pentru a îmbunătăți descrierea generală a domeniului cu un grafic de cunoștințe. [1] În timpul încorporării graficului de cunoștințe, aceste informații pot fi folosite pentru a învăța concretizări specializate pentru aceste caracteristici, împreună cu reprezentarea vectorială obișnuită a entităților și a relațiilor, cu prețul de a face învățarea mai costisitoare. [5]

- STransE [29] : Acest model este rezultatul combinării TransE și încorporării structurii [29] în așa fel încât să poată reprezenta cel mai bine relațiile unu-la-mulți, mulți la unu și mulți la mulți. [5] Pentru a face acest lucru, modelul prevede alte două matrice independente Și pentru fiecare relație încorporată în graficul de cunoștințe. [29] Fiecare matrice suplimentară este utilizată în funcție de relația specifică care interacționează cu capul sau coada triplului. [29] Cu alte cuvinte, dat fiind un fapt , înainte de a aplica traducerea vectorială, capul se înmulțește cu iar coada se înmulțește cu . [7]

- CrossE [30] : interacțiunile crossover pot fi utilizate pentru selectarea informațiilor conexe și ar putea fi foarte utile pentru procedura de încorporare. [30] Interacțiunile încrucișate oferă două contribuții distincte la selectarea informațiilor: interacțiunile relație-entitate și interacțiunile entitate-relație. [30] Aceasta înseamnă că o relație, de ex. „president_of” selectează automat tipurile de entități care leagă subiectul de subiectul unui fapt. [30] În mod similar, amploarea unui fapt determină în mod inadecvat ce cale de inferență trebuie aleasă pentru a prezice obiectul unui triplu corelat. [30] CrossE, pentru a face acest lucru, învață o matrice de interacțiune suplimentară , și folosește produsul element cu element pentru a calcula interacțiunea dintre Și . [5] [30] Deși CrossE nu se bazează pe o arhitectură de rețea neuronală, se arată că această metodologie poate fi codificată într-o astfel de arhitectură. [1]

Modele rototranslaționale

Această familie de modele, pe lângă sau în locul unei traduceri, utilizează o transformare rotativă. [5]

- TorusE [31] : Termenul de regularizare al TransE determină entitățile încorporate să construiască un spațiu sferic și, în consecință, acest spațiu pierde proprietățile de translație ale spațiului geometric. [31] Pentru a rezolva această problemă, TorusE exploatează utilizarea unui grup Lie compact care, în acest caz specific, este spațiul toroidal n-dimensional și evită utilizarea regularizării. [1] [31] TorusE definește funcțiile de distanță pentru a înlocui norma L1 și L2 a TransE. [5]

- RotatE [32] : RotatE este inspirat de identitatea lui Euler și prevede utilizarea produsului Hadmard pentru a reprezenta o relație ca o răsucire din cap spre coadă în spațiul complex. [32] Pentru fiecare element al triplului, partea complexă a încorporării descrie o rotație în sens invers acelor de ceasornic față de o axă, care poate fi descrisă cu identitatea Euler, în timp ce modulul vectorului relației este 1. [32] S-a dovedit că modelul este capabil să încorporeze relații simetrice, asimetrice, de inversare și compoziție din graficul de cunoștințe. [32]

Modele de învățare profundă

Acest grup de modele de încorporare utilizează rețele neuronale profunde pentru a învăța semantica din graficul de cunoștințe care reprezintă datele de intrare în rețea. [5] Aceste modele au generalitatea de a distinge tipul de entitate și relație, informațiile temporale, informațiile de cale, informațiile structurate care stau la baza [17] și rezolvă limitările modelelor bazate pe distanță și corespondența semantică în reprezentarea tuturor caracteristicilor unui grafic de cunoaștere. . [1] Utilizarea învățării profunde pentru încorporarea graficului de cunoștințe a arătat performanțe predictive bune, chiar dacă sunt mai scumpe în faza de instruire, au nevoie de mai multe date pentru instruire și deseori necesită o reprezentare a încorporării pre-instruite a graficului de cunoștințe dintr-un model diferit. [1] [5]

Rețele neuronale convoluționale

Această familie de modele, în loc să utilizeze straturi neuronale complet conectate, folosește unul sau mai multe straturi convoluționale care aplică convoluție asupra datelor de intrare prin aplicarea unui filtru de dimensiuni reduse capabil să încorporeze structuri complexe cu puțini parametri, învățând caracteristici neliniare. [1] [5] [17]

- ConvE [33] : ConvE este un model de încorporare care reprezintă un compromis bun între expresivitatea modelelor de învățare profundă și cheltuielile de calcul, [15] de fapt s-a demonstrat că a folosit de 8 ori mai puțini parametri, comparativ cu DistMult. [33] ConvE folosește o matrice de încorporare a dimensiunii unidimensionale să reprezinte entitățile și relațiile unui grafic de cunoaștere. [5] [33] Pentru a calcula funcția de scor a unui triplu, ConvE aplică o procedură simplă: mai întâi concatenează întruchipările triplului cap și relația într-o singură dată , atunci această matrice este utilizată ca intrare pentru nivelul convoluțional 2D. [5] [15] Rezultatul este apoi trecut printr-un strat neuronal dens care aplică o transformare liniară parametrizată de matrice și în cele din urmă, cu produsul interior este legat de coada triplului. [17] ConvE este, de asemenea, deosebit de eficient în procedura de evaluare: folosind un scor 1-N, modelul se potrivește, având un cap și o relație, toate cozile posibile în același timp, economisind mult timp în evaluare în comparație cu evaluarea 1-1 a celorlalte modele. [17]

- ConvR [34] : ConvR este o rețea convoluțională adaptivă menită să reprezinte în profunzime toate interacțiunile posibile dintre entități și relații. [34] Pentru această activitate, ConvR calculează filtrul convoluțional pentru fiecare relație și, atunci când este necesar, aplică aceste filtre entității de interes pentru a extrage caracteristicile complicate. [34] Procedura pentru calcularea triplului scor este aceeași ca și pentru ConvE. [5]

- ConvKB [35] : ConvKB, pentru a calcula funcția de scor a unui triplu dat , produce o intrare de dimensiune fără remodelare și îl trece la seria de filtru convoluțional de dimensiuni . [35] Acest rezultat alimentează un strat dens cu un singur neuron care produce scorul final. [35] Singurul neuron final, face ca această arhitectură să fie un clasificator binar în care faptul ar putea fi adevărat sau fals. [5] O diferență cu ConvE este că dimensionalitatea entităților nu este modificată. [15]

ConvKB, pentru a calcula funcția de scor a unei date triple , genera un input di dimensione senza cambiarne le dimensioni e lo trasferisce a una serie di filtri convoluzionali di dimensioni . [35] Questo risultato alimenta uno strato neurale denso con un solo neurone che produce il punteggio finale. [35] Il singolo neurone finale, rende questa architettura un classificatore binario in cui il fatto può essere vero o falso. [5] A differenza di ConvE, la dimensionalità delle entità non viene modificata durante il processo convolutivo. [15]

Reti neurali a capsula

Questa famiglia di modelli utilizza reti neurali a capsule per creare una rappresentazione più stabile in grado di riconoscere una caratteristica nell'input senza perdere informazioni spaziali. [5] La rete è composta da strati convoluzionali ma che sono organizzati in capsule, in gruppo, e il risultato complessivo di una capsula viene inviato ad un'altra capsula di livello superiore scelta da una routine di processo dinamica. [5]

- CapsE [36] : CapsE implementa una rete di capsule per modellare un fatto . [36] Come in ConvKB, ogni elemento della tripla è concatenato per costruire una matrice e viene usato per alimentare uno strato convoluzionale per estrarre le caratteristiche convoluzionali.. [5] [36] Queste caratteristiche vengono poi reindirizzate a una capsula per produrre un vettore continuo, più il vettore è lungo, più il fatto è vero. [36]

Reti neurali ricorrenti

Questa classe di modelli sfrutta l'uso della reti neurali ricorrenti. [5] Il vantaggio di questa architettura è memorizzare una sequenza di fatti, piuttosto che elaborare singoli eventi. [37]

- RSN [37] : Durante la procedura di incorporamento si presume comunemente che entità simili abbiano relazioni simili. [37] In pratica, questo tipo di informazioni non viene sfruttata, perché l'incorporamento viene calcolato solo sul fatto in corso piuttosto che sulla storia dei fatti. [37] Recurrent skipping network (RSN) utilizza una rete neurale ricorrente per apprendere il percorso relazionale utilizzando un campionamento casuale. [5] [37]

Performance dei modelli

Il task della predizione dei collegamenti nel contesto dell'incorporamento dei grafi della conoscenza viene molto spesso usato per valutare la precisione dei modelli nell'apprendere l'incorporamento. [1] [3] [5] [6] [7] [17] Rossi et al. [5] ha prodotto un benchmark estensivo sui modelli, ma anche altre analisi hanno prodotto risultati simili. [3] [7] [17] [24] Il benchmark usa cinque dataset FB15k [9] , WN18 [9] , FB15k-237 [38] , WN18RR [33] , e YAGO3-10 [39] . Più recentemente è stato discusso che questi dataset non rappresentano molto le applicazioni quotidiane e altri dataset dovrebbero essere integrati nel benchmark. [40]

| Nome del dataset | Numero di entità differenti | Numero di relazioni differenti | Numero di triple |

|---|---|---|---|

| FB15k [9] | 14951 | 1345 | 584113 |

| WN18 [9] | 40943 | 18 | 151442 |

| FB15k-237 [38] | 14541 | 237 | 310116 |

| WN18RR [33] | 40943 | 11 | 93003 |

| YAGO3-10 [39] | 123182 | 37 | 1089040 |

| Nome del dataset | Complessità di memoria | FB15K (Hits@10) | FB15K (MR) | FB15K (MRR) | FB15K - 237 (Hits@10) | FB15K - 237 (MR) | FB15K - 237 (MRR) | WN18 (Hits@10) | WN18 (MR) | WN18 (MRR) | WN18RR (Hits@10) | WN18RR (MR) | WN18RR (MRR) | YAGO3-10 (Hits@10) | YAGO3-10 (MR) | YAGO3-10 (MRR) |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| DistMul [18] | 0.863 | 173 | 0.784 | 0.490 | 199 | 0.313 | 0.946 | 675 | 0.824 | 0.502 | 5913 | 0.433 | 0.661 | 1107 | 0.501 | |

| ComplEx [19] | 0.905 | 34 | 0.848 | 0.529 | 202 | 0.349 | 0.955 | 3623 | 0.949 | 0.521 | 4907 | 0.458 | 0.703 | 1112 | 0.576 | |

| ANALOGY [20] | 0.837 | 126 | 0.726 | 0.353 | 476 | 0.202 | 0.944 | 808 | 0.934 | 0.380 | 9266 | 0.366 | 0.456 | 2423 | 0.283 | |

| SimplE [21] | 0.836 | 138 | 0.726 | 0.343 | 651 | 0.179 | 0.945 | 759 | 0.938 | 0.426 | 8764 | 0.398 | 0.631 | 2849 | 0.453 | |

| HolE [22] | 0.867 | 211 | 0.800 | 0.476 | 186 | 0.303 | 0.949 | 650 | 0.938 | 0.487 | 8401 | 0.432 | 0.651 | 6489 | 0.502 | |

| TuckER [23] | 0.888 | 39 | 0.788 | 0.536 | 162 | 0.352 | 0.958 | 510 | 0.951 | 0.514 | 6239 | 0.459 | 0.680 | 2417 | 0.544 | |

| TransE [9] | 0.847 | 45 | 0.628 | 0.497 | 209 | 0.310 | 0.948 | 279 | 0.646 | 0.495 | 3936 | 0.206 | 0.673 | 1187 | 0.501 | |

| STransE [29] | 0.796 | 69 | 0.543 | 0.495 | 357 | 0.315 | 0.934 | 208 | 0.656 | 0.422 | 5172 | 0.226 | 0.073 | 5797 | 0.049 | |

| CrossE [30] | 0.862 | 136 | 0.702 | 0.470 | 227 | 0.298 | 0.950 | 441 | 0.834 | 0.449 | 5212 | 0.405 | 0.654 | 3839 | 0.446 | |

| TorusE [31] | 0.839 | 143 | 0.746 | 0.447 | 211 | 0.281 | 0.954 | 525 | 0.947 | 0.535 | 4873 | 0.463 | 0.474 | 19455 | 0.342 | |

| RotatE [32] | 0.881 | 42 | 0.791 | 0.522 | 178 | 0.336 | 0.960 | 274 | 0.949 | 0.573 | 3318 | 0.475 | 0.570 | 1827 | 0.498 | |

| ConvE [33] | 0.849 | 51 | 0.688 | 0.521 | 281 | 0.305 | 0.956 | 413 | 0.945 | 0.507 | 4944 | 0.427 | 0.657 | 2429 | 0.488 | |

| ConvKB [35] | 0.408 | 324 | 0.211 | 0.517 | 309 | 0.230 | 0.948 | 202 | 0.709 | 0.525 | 3429 | 0.249 | 0.604 | 1683 | 0.420 | |

| ConvR [34] | 0.885 | 70 | 0.773 | 0.526 | 251 | 0.346 | 0.958 | 471 | 0.950 | 0.526 | 5646 | 0.467 | 0.673 | 2582 | 0.527 | |

| CapsE [36] | 0.217 | 610 | 0.087 | 0.356 | 405 | 0.160 | 0.950 | 233 | 0.890 | 0.559 | 720 | 0.415 | 0 | 60676 | 0.000 | |

| RSN [37] | 0.870 | 51 | 0.777 | 0.444 | 248 | 0.280 | 0.951 | 346 | 0.928 | 0.483 | 4210 | 0.395 | 0.664 | 1339 | 0.511 |

Librerie

- ( EN ) KGE , su GitHub .

- ( EN ) Pykg2vec , su GitHub .

- ( EN )DGL-KE , su GitHub .

- ( EN ) PyKEEN , su GitHub .

- ( EN ) TorchKGE , su GitHub .

- ( EN ) AmpliGraph , su GitHub .

- ( EN ) OpenKE , su GitHub .

- ( EN ) scikit-kge , su GitHub .

- ( EN ) Fast-TransX , su GitHub .

Voci correlate

- Knowledge graph

- Embedding

- Machine learning

- Knowledge base

- Knowledge extraction

- Statistical relational learning

- Representation learning

- Graph embedding

Collegamenti esterni

Note

- ^ a b c d e f g h i j k l m n o p q r s t u v w x y z aa Shaoxiong Ji, Shirui Pan, Erik Cambria, Pekka Marttinen e Philip S. Yu, A Survey on Knowledge Graphs: Representation, Acquisition, and Applications , in IEEE Transactions on Neural Networks and Learning Systems , 2021, pp. 1-21, DOI : 10.1109/TNNLS.2021.3070843 , ISSN 2162-237X .

- ^ ( EN ) Sameh K Mohamed, Vít Nováček e Aayah Nounu, Discovering Protein Drug Targets Using Knowledge Graph Embeddings , in Lenore Cowen (a cura di), Bioinformatics , 1º agosto 2019, pp. btz600, DOI :10.1093/bioinformatics/btz600 , ISSN 1367-4803 .

- ^ a b c d Yankai Lin, Xu Han, Ruobing Xie, Zhiyuan Liu e Maosong Sun, Knowledge Representation Learning: A Quantitative Review , in arXiv:1812.10901 [cs] , 28 dicembre 2018.

- ^ a b c ( EN ) Bilal Abu-Salih, Marwan Al-Tawil, Ibrahim Aljarah, Hossam Faris, Pornpit Wongthongtham, Kit Yan Chan e Amin Beheshti, Relational Learning Analysis of Social Politics using Knowledge Graph Embedding , in Data Mining and Knowledge Discovery , 12 maggio 2021, DOI : 10.1007/s10618-021-00760-w , ISSN 1573-756X .

- ^ a b c d e f g h i j k l m n o p q r s t u v w x y z aa ab ac ad ae af ag ah ai aj ak al am an ao ap aq ar as ( EN ) Andrea Rossi, Denilson Barbosa, Donatella Firmani, Antonio Matinata e Paolo Merialdo, Knowledge Graph Embedding for Link Prediction: A Comparative Analysis , in ACM Transactions on Knowledge Discovery from Data , vol. 15, n. 2, 2020, pp. 1-49, DOI : 10.1145/3424672 , ISSN 1556-4681 .

- ^ a b Heiko Paulheim, Knowledge graph refinement: A survey of approaches and evaluation methods , in Philipp Cimiano (a cura di), Semantic Web , vol. 8, n. 3, 6 dicembre 2016, pp. 489-508, DOI : 10.3233/SW-160218 .

- ^ a b c d e f g h i j k l m n o p q r s t u v w x y z aa ab ( EN ) Yuanfei Dai, Shiping Wang, Neal N. Xiong e Wenzhong Guo, A Survey on Knowledge Graph Embedding: Approaches, Applications and Benchmarks , in Electronics , vol. 9, n. 5, maggio 2020, p. 750, DOI : 10.3390/electronics9050750 .

- ^ ( EN ) Shu Guo, Quan Wang, Bin Wang, Lihong Wang e Li Guo, Semantically Smooth Knowledge Graph Embedding , in Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing (Volume 1: Long Papers) , Beijing, China, Association for Computational Linguistics, 2015, pp. 84-94, DOI : 10.3115/v1/P15-1009 .

- ^ a b c d e f g Antoine Bordes, Nicolas Usunier, Alberto Garcia-Durán, Jason Weston e Oksana Yakhnenko, Translating embeddings for modeling multi-relational data , in Proceedings of the 26th International Conference on Neural Information Processing Systems - Volume 2 , NIPS'13, Lake Tahoe, Nevada, Curran Associates Inc., maggio 2013, pp. 2787-2795.

- ^ a b c d e f g h i j Zhe Chen, Yuehan Wang, Bin Zhao, Jing Cheng, Xin Zhao e Zongtao Duan, Knowledge Graph Completion: A Review , in IEEE Access , vol. 8, 2020, pp. 192435-192456, DOI : 10.1109/ACCESS.2020.3030076 , ISSN 2169-3536 .

- ^ a b c d e Hongyun Cai, Vincent W. Zheng e Kevin Chen-Chuan Chang, A Comprehensive Survey of Graph Embedding: Problems, Techniques and Applications , in arXiv:1709.07604 [cs] , 2 febbraio 2018.

- ^ a b Sijin Zhou, Xinyi Dai, Haokun Chen, Weinan Zhang, Kan Ren, Ruiming Tang, Xiuqiang He e Yong Yu, Interactive Recommender System via Knowledge Graph-enhanced Reinforcement Learning , in arXiv:2006.10389 [cs] , 18 giugno 2020.

- ^ Chan Liu, Lun Li, Xiaolu Yao e Lin Tang, A Survey of Recommendation Algorithms Based on Knowledge Graph Embedding , in 2019 IEEE International Conference on Computer Science and Educational Informatization (CSEI) , agosto 2019, pp. 168-171, DOI : 10.1109/CSEI47661.2019.8938875 .

- ^ Daniel N. Sosa, Alexander Derry, Margaret Guo, Eric Wei, Connor Brinton e Russ B. Altman, A Literature-Based Knowledge Graph Embedding Method for Identifying Drug Repurposing Opportunities in Rare Diseases , in Pacific Symposium on Biocomputing. Pacific Symposium on Biocomputing , vol. 25, 2020, pp. 463-474, ISSN 2335-6936 , PMC 6937428 , PMID 31797619 .

- ^ a b c d e f g h i j k l ( EN ) Mona Alshahrani, Maha A. Thafar e Magbubah Essack, Application and evaluation of knowledge graph embeddings in biomedical data , in PeerJ Computer Science , vol. 7, 18 febbraio 2021, pp. e341, DOI : 10.7717/peerj-cs.341 , ISSN 2376-5992 , PMC PMC7959619 , PMID 33816992 .

- ^ Maximilian Nickel, Volker Tresp e Hans-Peter Kriegel, A three-way model for collective learning on multi-relational data , in Proceedings of the 28th International Conference on International Conference on Machine Learning , ICML'11, Bellevue, Washington, USA, Omnipress, 28 giugno 2011, pp. 809-816, ISBN 978-1-4503-0619-5 .

- ^ a b c d e f g h i j k ( EN ) Meihong Wang, Linling Qiu e Xiaoli Wang, A Survey on Knowledge Graph Embeddings for Link Prediction , in Symmetry , vol. 13, n. 3, 16 marzo 2021, p. 485, DOI : 10.3390/sym13030485 , ISSN 2073-8994 .

- ^ a b Bishan Yang, Wen-tau Yih, Xiaodong He, Jianfeng Gao e Li Deng, Embedding Entities and Relations for Learning and Inference in Knowledge Bases , in arXiv:1412.6575 [cs] , 29 agosto 2015.

- ^ a b c Théo Trouillon, Johannes Welbl, Sebastian Riedel, Éric Gaussier e Guillaume Bouchard, Complex Embeddings for Simple Link Prediction , in arXiv:1606.06357 [cs, stat] , 20 giugno 2016.

- ^ a b c d e Hanxiao Liu, Yuexin Wu e Yiming Yang, Analogical Inference for Multi-Relational Embeddings , in arXiv:1705.02426 [cs] , 6 luglio 2017.

- ^ a b c Seyed Mehran Kazemi e David Poole, SimplE Embedding for Link Prediction in Knowledge Graphs , in arXiv:1802.04868 [cs, stat] , 25 ottobre 2018.

- ^ a b c Maximilian Nickel, Lorenzo Rosasco e Tomaso Poggio, Holographic Embeddings of Knowledge Graphs , in arXiv:1510.04935 [cs, stat] , 7 dicembre 2015.

- ^ a b c d Ivana Balažević, Carl Allen e Timothy M. Hospedales, TuckER: Tensor Factorization for Knowledge Graph Completion , in Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP) , 2019, pp. 5184-5193, DOI : 10.18653/v1/D19-1522 .

- ^ a b Mehdi Ali, Max Berrendorf, Charles Tapley Hoyt, Laurent Vermue, Mikhail Galkin, Sahand Sharifzadeh, Asja Fischer, Volker Tresp e Jens Lehmann, Bringing Light Into the Dark: A Large-scale Evaluation of Knowledge Graph Embedding Models Under a Unified Framework , in arXiv:2006.13365 [cs, stat] , 29 dicembre 2020.

- ^ a b Zhen Wang, Knowledge Graph Embedding by Translating on Hyperplanes , in AAAI Publications, Twenty-Eighth AAAI Conference on Artificial Intelligence , 2014.

- ^ Yankai Lin, Zhiyuan Liu, Maosong Sun, Yang Liu e Xuan Zhu, Learning entity and relation embeddings for knowledge graph completion , in Proceedings of the Twenty-Ninth AAAI Conference on Artificial Intelligence , AAAI'15, Austin, Texas, AAAI Press, 25 gennaio 2015, pp. 2181-2187, ISBN 978-0-262-51129-2 .

- ^ a b c d e Guoliang Ji, Shizhu He, Liheng Xu, Kang Liu e Jun Zhao, Knowledge Graph Embedding via Dynamic Mapping Matrix , in Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing (Volume 1: Long Papers) , Beijing, China, Association for Computational Linguistics, luglio 2015, pp. 687-696, DOI : 10.3115/v1/P15-1067 .

- ^ a b c Han Xiao, Minlie Huang, Yu Hao e Xiaoyan Zhu, TransA: An Adaptive Approach for Knowledge Graph Embedding , in arXiv:1509.05490 [cs] , 27 settembre 2015.

- ^ a b c d e Dat Quoc Nguyen, Kairit Sirts, Lizhen Qu e Mark Johnson, STransE: a novel embedding model of entities and relationships in knowledge bases , in Proceedings of the 2016 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies , San Diego, California, Association for Computational Linguistics, giugno 2016, pp. 460-466, DOI : 10.18653/v1/N16-1054 .

- ^ a b c d e f g Wen Zhang, Bibek Paudel, Wei Zhang, Abraham Bernstein e Huajun Chen, Interaction Embeddings for Prediction and Explanation in Knowledge Graphs , in Proceedings of the Twelfth ACM International Conference on Web Search and Data Mining , 30 gennaio 2019, pp. 96-104, DOI : 10.1145/3289600.3291014 .

- ^ a b c d Takuma Ebisu e Ryutaro Ichise, TorusE: Knowledge Graph Embedding on a Lie Group , in arXiv:1711.05435 [cs] , 15 novembre 2017.

- ^ a b c d e Zhiqing Sun, Zhi-Hong Deng, Jian-Yun Nie e Jian Tang, RotatE: Knowledge Graph Embedding by Relational Rotation in Complex Space , in arXiv:1902.10197 [cs, stat] , 26 febbraio 2019.

- ^ a b c d e f Tim Dettmers, Pasquale Minervini, Pontus Stenetorp e Sebastian Riedel, Convolutional 2D Knowledge Graph Embeddings , in arXiv:1707.01476 [cs] , 4 luglio 2018.

- ^ a b c d Xiaotian Jiang, Quan Wang e Bin Wang, Adaptive Convolution for Multi-Relational Learning , in Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers) , Minneapolis, Minnesota, Association for Computational Linguistics, giugno 2019, pp. 978-987, DOI : 10.18653/v1/N19-1103 .

- ^ a b c d e f Dai Quoc Nguyen, Tu Dinh Nguyen, Dat Quoc Nguyen e Dinh Phung, A Novel Embedding Model for Knowledge Base Completion Based on Convolutional Neural Network , in Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 2 (Short Papers) , 2018, pp. 327-333, DOI : 10.18653/v1/N18-2053 .

- ^ a b c d e Dai Quoc Nguyen, Thanh Vu, Tu Dinh Nguyen, Dat Quoc Nguyen e Dinh Phung, A Capsule Network-based Embedding Model for Knowledge Graph Completion and Search Personalization , in arXiv:1808.04122 [cs] , 6 marzo 2019.

- ^ a b c d e f Lingbing Guo, Zequn Sun e Wei Hu, Learning to Exploit Long-term Relational Dependencies in Knowledge Graphs , in arXiv:1905.04914 [cs] , 13 maggio 2019.

- ^ a b Kristina Toutanova e Danqi Chen, Observed versus latent features for knowledge base and text inference , in Proceedings of the 3rd Workshop on Continuous Vector Space Models and their Compositionality , Beijing, China, Association for Computational Linguistics, luglio 2015, pp. 57-66, DOI : 10.18653/v1/W15-4007 .

- ^ a b F. Mahdisoltani, J. Biega e Fabian M. Suchanek, YAGO3: A Knowledge Base from Multilingual Wikipedias , in CIDR , 2015.

- ^ Weihua Hu, Matthias Fey, Marinka Zitnik, Yuxiao Dong, Hongyu Ren, Bowen Liu, Michele Catasta e Jure Leskovec, Open Graph Benchmark: Datasets for Machine Learning on Graphs , in arXiv:2005.00687 [cs, stat] , 24 febbraio 2021.

![{\ displaystyle = {\ frac {| \ {q \ în Q: q <k \} |} {| Q |}} \ in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cd0b504a6a4026009b8f5a0c39ad0ce4c88e5977)

![{\ displaystyle MRR = {\ frac {1} {| Q |}} \ sum _ {q \ in Q} {\ frac {1} {q}} \ in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/adf9b1771d7ac872c4d3082c26b15e8eb9f3e512)

![{\ displaystyle {\ ce {[h; {\ mathcal {r}}]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4754a8e29d7b4ccd4cf13de3052aef0922840171)

![{\ displaystyle {\ ce {[h; {\ mathcal {r}}; t]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fb32c4cfc9fa12eb799777f7234990ce33b3d544)